Mini-robots en essaim pour l’affichage interactif

24 novembre 2016

sur

sur

Zooids est le nom d'une plateforme ouverte, matériel et logiciel, pour la conception d'interfaces dites tabletop Swarm User Interfaces, un nouveau type d'interfaces homme-machine constitué de nombreux mini-robots mobiles (partiellement) autonomes, qui assurent, en se déplaçant sur une table, la double fonction d'afficheur (ou d'indicateur) et d'organe de saisie d'information et donc d'interaction.

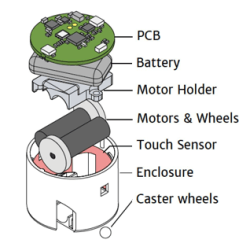

Zooids est le nom d'une plateforme ouverte, matériel et logiciel, pour la conception d'interfaces dites tabletop Swarm User Interfaces, un nouveau type d'interfaces homme-machine constitué de nombreux mini-robots mobiles (partiellement) autonomes, qui assurent, en se déplaçant sur une table, la double fonction d'afficheur (ou d'indicateur) et d'organe de saisie d'information et donc d'interaction.Outre les robots, la plate-forme comprend une carte de communication sans fil et un projecteur de lumière structurée à grande vitesse pour le suivi optique. Chacun des 100 robots (à ce jour) au corps cylindrique de 2 cm de diamètre, est doté de petites roues et de capteurs de lumière pour la localisation, ainsi que de capteurs tactiles et de mouvement.

Cette recherche menée par Mathieu Le Goc, Lawrence Kim, Ali Parsaei, Jean-Daniel Fekete, Pierre Dragicevic et Sean Follmer a été présenté le mois dernier à Tokyo, par Mathieu Le Goc, doctorant au sein de l’équipe AVIZ du centre Inria Saclay - Île-de-France, dans le cadre de la conférence UIST2016 (User Interface Software and Technology). La lecture de leur publication est très intéressante ; il n'est pas surprenant qu'elle ait été distinguée à l'issue de la conférence par le prix du meilleur article.

De l’ordinateur aux robots

La lumière structurée envoyée par le projecteur est le vecteur des informations adressées par l’ordinateur aux robots ; elle permet de localiser le robot et son orientation. Les robots ne sont pas autonomes, c’est l’ordinateur qui coordonne leur mouvements et leur mode de regroupement selon le principe des essaims d’insectes sociaux (fourmis, abeilles), ou des oiseaux migrateurs.Des robots à l’ordinateur

La transmission d’informations est bidirectionnelle. Les capteurs de localisation sur les robots permettent à l’ordinateur de visualiser sur l’écran la disposition et les mouvements des robots. Les manipulations des robots par l’utilisateur sont détectées grâce aux capteurs tactiles.Tactile et virtuel

La nouveauté de ce mode d’interaction homme-machine réside en effet dans l’absence d’écran : c’est la vue des robots par l’utilisateur de l’interface et leur manipulation par lui qui lui permettent d’interagir avec le système.Pour la localisation des robots, cette plateforme n’utilise pas d’aimants ni pour leur localication, effectuée par projection d’une trame lumineuse, ni pour leur déplacement, obtenu avec des roues. Pour l’affichage, les robots fonctionnent comme les pixels dans un graphisme.

Il reste à trouver et mettre au point des applications qui tireront parti de ce mode d’interfaçage, qui associe le tactile et le virtuel. C'est pourquoi les auteurs ont mis à la disposition de tous sur Github les informations requises sur le matériel et le logiciel !

Lire l'article complet

Hide full article

Discussion (0 commentaire(s))